Стихи от роботов — искусство? Можно ли обмануть ИИ? Отвечаем на философские вопросы об ИИ

Интерес к теме искусственного интеллекта (ИИ) в России в последнее время поистине огромный: утверждена Национальная стратегия развития ИИ до 2030 года, подписанная президентом РФ Владимиром Путиным, создан альянс с ведущими компаниями, а в обновленную нацпрограмму «Цифровая экономика» вошел седьмой федеральный проект «Искусственный интеллект». При этом пока страны внедряют ИИ во все сферы экономики и общества, ученые и программисты бьются над этическими и философскими проблемами. Портал национальныепроекты.рф вместе с экспертами отвечает на самые интересные этические вопросы об ИИ.

Почему голосовые помощники используют женские голоса?

Есть различные теории, почему голосовые помощники чаще всего говорят именно женскими голосами. Например, Siri, «Алиса», Cortana. Так, профессор Стэнфордского университета Клиффорд Насс в своем интервью CNN в 2011 году предположил, что люди просто запрограммированы на то, чтобы им больше нравились женские голоса, и что гораздо проще найти голос женщины, который нравился бы широкому кругу пользователей, чем мужчины. В частности, он апеллировал к исследованиям, которые связывали такую запрограммированность с тем, что дети в утробе матери большую часть времени слышат именно женский голос.

В чем уже сейчас ИИ превосходит человека?

ИИ превосходит человека в задачах, требующих быстроты реакции. «Можно сказать, что наши прикладные системы ИИ реализуют пока в основном интеллектуальную, но относительно рутинную работу», — отмечает директор по перспективным технологиям Microsoft в России Владислав Шершульский. Например, сельскохозяйственный комбайн с элементами ИИ анализирует каждый листик на поле на наличие вредителей и при необходимости обрабатывает его отдельно. Никакой человек не смог бы выполнить такую тяжелую, кропотливую работу. Именно поэтому коллаборация человека и ИИ может принести огромную пользу, уверен эксперт.

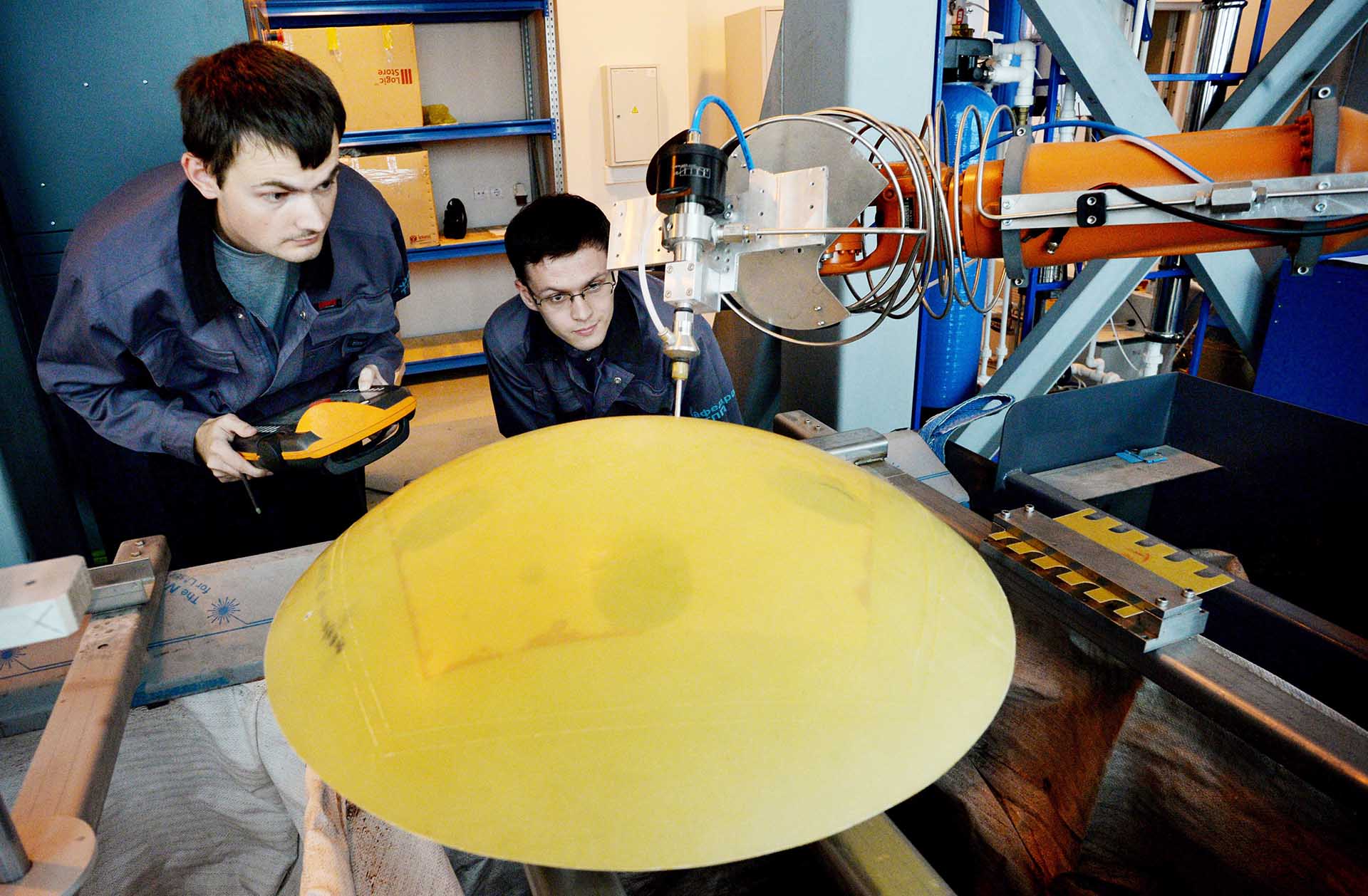

Евгений Биятов/РИА Новости

По словам заместителя директора по технологиям и разработкам компании ABBYY Татьяны Даниэлян, алгоритмы любят рутину: они могут извлекать важные данные из десятков миллионов документов, отслеживать показания тысяч датчиков на заводе, распознавать лица в огромном потоке людей. «Это и сила, и слабость ИИ: лучше всего он справляется с задачами, которые многократно повторяются. Сложные задачи со множеством исключений пока ИИ не под силу», — подчеркивает она.

Как разрабатывать и внедрять программы анализа данных, избегая при этом слежки и контроля за людьми? Где граница между прогрессом и личной жизнью?

Новые технологии наряду с новыми возможностями несут и новые риски, а также огромную ответственность для тех, кто их разрабатывает, считает Шершульский. Ошибка может спровоцировать негативные экономические и социальные последствия, надолго скомпрометировать технологию в глазах общества. Поэтому соблюдение этики ИИ требует усилий как отдельных компаний, так и рынка в целом. «В нашем понимании ИИ обязательно включает встроенную защиту конфиденциальности, безопасности и соблюдения целого ряда требований прозрачности, непредвзятости и прочего», — отмечает он.

Сейчас ИИ уже пишет стихи, картины, сочиняет песни. Может ли это считаться искусством? Если да, то будет ли это охраняться авторским правом?

Роботы — композиторы, поэты, художники, созданные с помощью алгоритмов глубокого машинного обучения, удачно воссоздают или имитируют существующий опыт — произведения в духе того или иного «живого» автора. Например, широкую известность получили проекты The Next Rembrandt и «НейроСкрябин». В прошлом году нейросеть помогла дописать неоконченную симфонию чешского композитора Дворжака.

«На мой взгляд, это не творчество в широком смысле слова, а еще один интересный инструмент для творческой личности, — говорит Даниэлян. — Технические специалисты создают нейросеть, а артисты используют ее возможности для создания своих работ».

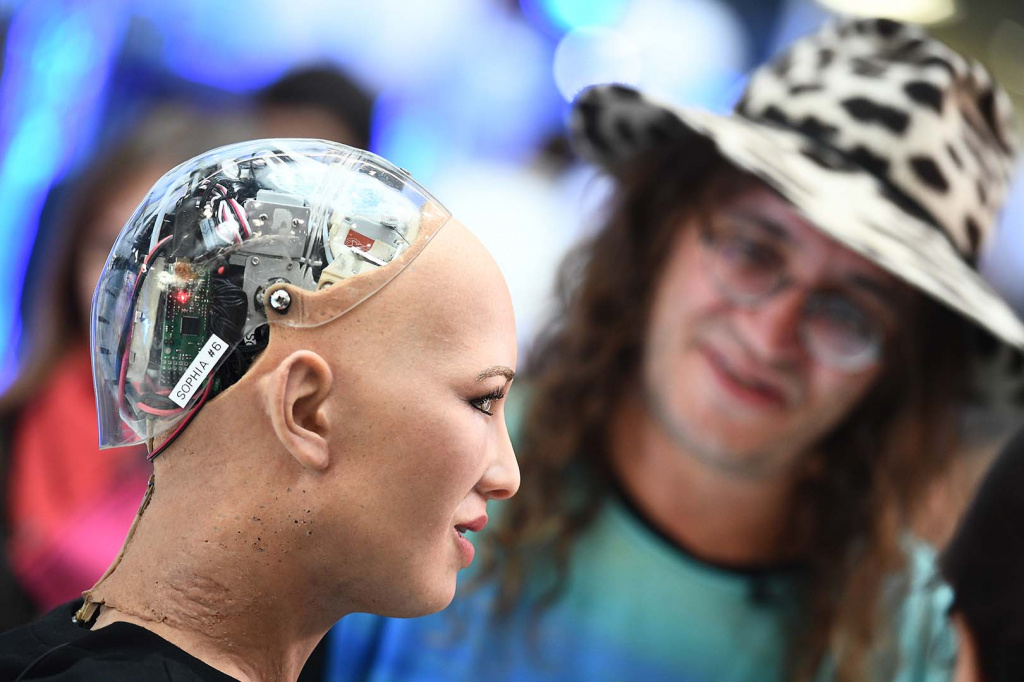

Рамиль Ситдиков/РИА Новости

Главный вопрос в таких проектах — как оценивать степень оригинальности, соглашаются эксперты. Уже известны случаи, когда ИИ обвиняли в плагиате. Так, в Канаде интеллектуальная система создавала абстрактные картины, определяла процент их похожести на работы реальных художников, а затем публиковала эти изображения на сайте. Один из авторов подал в суд на разработчиков за нанесение вреда своей репутации и копирование его работы.

Какие еще риски видят ученые?

Одно из опасений разработчиков ИИ в том, что с развитием технологий мы будем доверять все более сложные и ответственные решения машинам. И речь идет даже не об игре в го или предсказании, какой трек понравится определенному пользователю, а о более опасных задачах как в военной сфере, так и, например, в здравоохранении.

Другая возможная проблема — потеря контроля над ИИ. Если ИИ будет подобен человеку, то сможет принимать и самостоятельные решения, а значит, «восстать» против своего создателя. Это один из любимых сценариев современных фантастических фильмов и книг.

Более актуальное опасение — потеря работы из-за роботов. Это то, что, скорее всего, произойдет в любом случае, пока продолжается технологический процесс и человек ищет возможности автоматизации всего и вся.

Возможно ли при программировании ИИ предусмотреть «аварийный выключатель» на случай непредвиденных угроз?

Выключатель есть у любой машины, но как вовремя увидеть непредвиденную угрозу в случае ИИ? «Сейчас самый популярный вид ИИ — машинное обучение на основе «нейронных сетей», — говорит эксперт отдела исследования угроз «Лаборатории Касперского» Алексей Андреев. — Почему в кавычках — никаких нейронов там нет и в помине, а есть несложные алгоритмы из прошлого века, основанные больше на статистике, чем на логике. Это приводит к проблеме интерпретации результатов — в случае ошибки вы просто не поймете, что случилось».

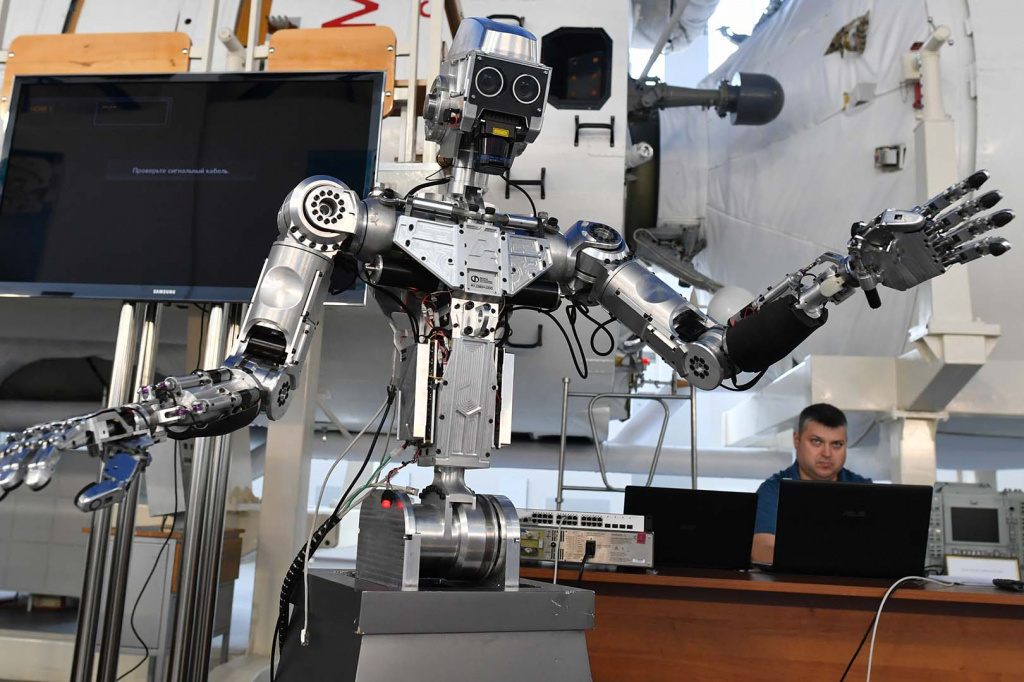

Кирилл Каллиников/РИА Новости

По его словам, сложность ИИ в том, что он не может объяснять свои поступки: «Сейчас уже бывают такие сбои ИИ, когда человеку отказались выдавать кредит в банке без объяснения причин или автомобильный навигатор построил совершенно кривой маршрут. Бывали случаи, когда людей принимали за преступников из-за ошибки системы распознавания лиц или ошибки автоматического перевода текста».

Можно ли обмануть ИИ?

Взлом ИИ — одна из самых горячих тем на конференциях по безопасности, соглашаются эксперты, особенно в области распознавания образов. Бывает достаточно нарисовать на лице полоску или поставить пятно на дорожном знаке — и система воспринимает объект как нечто совершенно иное. Часто такие возможности обмана связаны с тем, что системы ИИ обучаются на открытых данных из интернета.

Другой типичный случай: ИИ разрабатывается в стерильных условиях лаборатории и там показывает отличные результаты, но при использовании в реальном мире начинаются проблемы, отмечает Андреев. «Потому что в реальности среда агрессивная — взломщики будут специально забрасывать систему нестандартными картинками, причем атака будет автоматизирована с помощью вредоносного искусственного интеллекта. Сегодня во многих сферах уже задействованы системы машинного обучения, которые никто всерьез не тестировал на взлом и которые при этом не дублируются другими системами контроля, например экспертами-людьми», — поясняет он.

Правда ли, что ИИ, как и любые прорывные технологии, будет в первую очередь задействован в военной сфере?

Конечно, военные разработки в сфере ИИ идут давно во множестве стран. Что несет в себе ряд угроз, считают эксперты.

Михаил Воскресенский/РИА Новости

Дело в том, что самой удобной средой обитания для ИИ является интернет, то есть мы его не видим. «Почему мы не видим вокруг двуногих прямоходящих роботов, которых нам рисуют фантасты? Да потому что это сложный физический мир. Точно так же летающий военный дрон — дорогая игрушка, а сбить его можно из обычного ружья. Но совсем другое дело цифровой мир компьютерных сетей. Там даже простенький ИИ чувствует себя как рыба в воде, и эта рыба плавает там гораздо быстрее человека», — объясняет эксперт «Лаборатории Касперского».

Могут ли программы самообучения, которые лежат в основе ИИ, обучиться злости, любви или жалости? И почему?

70 лет назад английский математик Алан Тьюринг с подобных вопросов начал свою статью «Могут ли машины мыслить?». И его ответ был таков — мы до сих пор не знаем, что такое мышление и сознание, поэтому лучше сформулировать этот вопрос так: может ли машина имитировать человека таким образом, чтобы ее нельзя было отличить от человека? И Тьюринг показал, что при определенных условиях такую «обманку» построить можно, рассказывает Андреев.

Сегодня «тест Тьюринга» легко проходят фишинговые боты — это такой ИИ, который рассылает людям разнообразные «письма счастья», «письма жалости» или «письма-страшилки». И люди на них реагируют — отдают вредоносному роботу свои пароли или деньги. Точно так же работает таргетированная реклама, которая анализирует ваши персональные данные и подбрасывает вам объявления, заточенные под ваши личные страхи.

«Но при этом многие до сих пор верят, что искусственный интеллект не может работать с эмоциями, — продолжает Андреев. — Это еще один старый стереотип фантастики: робот хорошо играет в шахматы, но не понимает наших тонких чувств. Но ведь фишинговая рассылка и таргетированная реклама — это именно обман эмоций! Очевидно, что вскоре роботы будут анализировать эмоции людей не только по текстам, но и на основе более базовых реакций — мимики, голоса, пульса. А значит, скоро они научатся имитировать ваши эмоции не хуже, чем играть в шахматы».

При этом сегодня ИИ работает и для защиты от таких ботов. Технологии позволяют определить, настоящий пользователь вошел в свою учетную запись или злоумышленник. Для этого система сравнивает множество параметров: анализирует, какое устройство обычно используется, а также поведение, местоположение и т.д. На основании этого система может, например, предупредить сотрудников банка о мошеннических операциях.

Подпишитесь на новости национального проекта